Ipoacusia

L’accessibilità è tema urgente e se ne dibatte in numerosi contesti: a tutte le persone disabili deve essere garantito il diritto di accedere, al pari di tutti, a ogni ambito della vita. Molte attività accessibili alle persone udenti possono essere completamente inaccessibili per una persona sorda ledendo di fatto, e a tutti i livelli, il suo diritto alla salute, all’istruzione, al lavoro, alla socialità. Garantire la presenza di strumenti tecnologici adeguati e di figure professionali altrettanto adeguate, aumenta l’autonomia e l’indipendenza dei cittadini sordi.

Il progetto IPOACUSIA 2 “Innovare, Informare, Partecipare – nuove metodologie per la comunicazione delle persone sorde”, prosieguo del progetto Ipoacusia, nasce con l’intento di abbattere le barriere comunicative che ostacolano l’accesso ai servizi pubblici da parte delle persone sorde o con ipoacusia. L’obiettivo è quello di sviluppare una piattaforma tecnologica innovativa in grado di facilitare la comprensione e l’interazione tra cittadini sordi e Pubblica Amministrazione, attraverso la traduzione automatica della Lingua dei Segni Italiana (LIS).

Attualmente il progetto è in fase di sperimentazione, ed è in corso lo sviluppo e il perfezionamento di:

- un dataset video dedicato alla LIS, che raccoglie vocaboli e frasi di uso frequente nella comunicazione con gli enti pubblici;

- un sistema di riconoscimento automatico dei segni basato su tecnologie di intelligenza artificiale e visione artificiale;

- un avatar virtuale in grado di interpretare e riprodurre frasi in LIS;

- una piattaforma di streaming video in tempo reale per supportare la comunicazione a distanza.

“La battaglia per i Sordi è quella di essere sempre presenti nella vita sociale, di essere presenti direttamente, per abituare il mondo udente a parlare con i Sordi”

Francesco Olla • Con la S maiuscola. Lingua, cultura e identità Sorda Tweet

Presentazione del progetto IPOACUSIA 2 in LIS

Piattaforma Acquisizione Video LIS

Tutorial

Uno degli elementi chiave del progetto è la partecipazione attiva della comunità sorda. Stiamo avviando un processo collaborativo per:

- Ampliare il dataset linguistico, includendo un numero sempre maggiore di vocaboli, espressioni e frasi complete, rilevanti per le esigenze quotidiane.

- Testare la piattaforma, offrendo feedback pratico sull’usabilità, l’efficacia della traduzione automatica e le necessità reali degli utenti.

- Favorire la co-progettazione, coinvolgendo persone sorde, interpreti LIS ed esperti di accessibilità per migliorare costantemente il sistema.

Come contribuire all’arricchimento del dataset? È un processo rapido.

Nel video tutorial puoi trovare tutti gli step necessari per l’arricchimento della piattaforma.

Ipoacusia - prima edizione

Genesi del Progetto Ipoacusia

L’attuale programma – Ipoacusia 2 – è il followup del progetto Ipoacusia sviluppato dal CRS4 tra il 2020 e il 2022 con il finanziamento e il sostegno della Presidenza del Consiglio dei Ministri, della Regione Autonoma della Sardegna e di Sardegna Ricerche.

Il progetto di ricerca “Innovare, Informare, Partecipare – nuove metodologie per la comunicazione delle persone sorde” nasceva dall’ambizione, fortemente sostenuta dalle Autorità Regionali sarde, di ridurre le barriere comunicative tra le persone sorde e la Pubblica Amministrazione. Nell’ambito del progetto, abbiamo sviluppato e testato strumenti di traduzione automatica della LIS, basati su modelli di intelligenza artificiale, raggiungendo lo stato dell’arte a livello internazionale per contribuire a migliorare il livello di accessibilità e autonomia delle persone sorde negli ambiti della vita quotidiana.

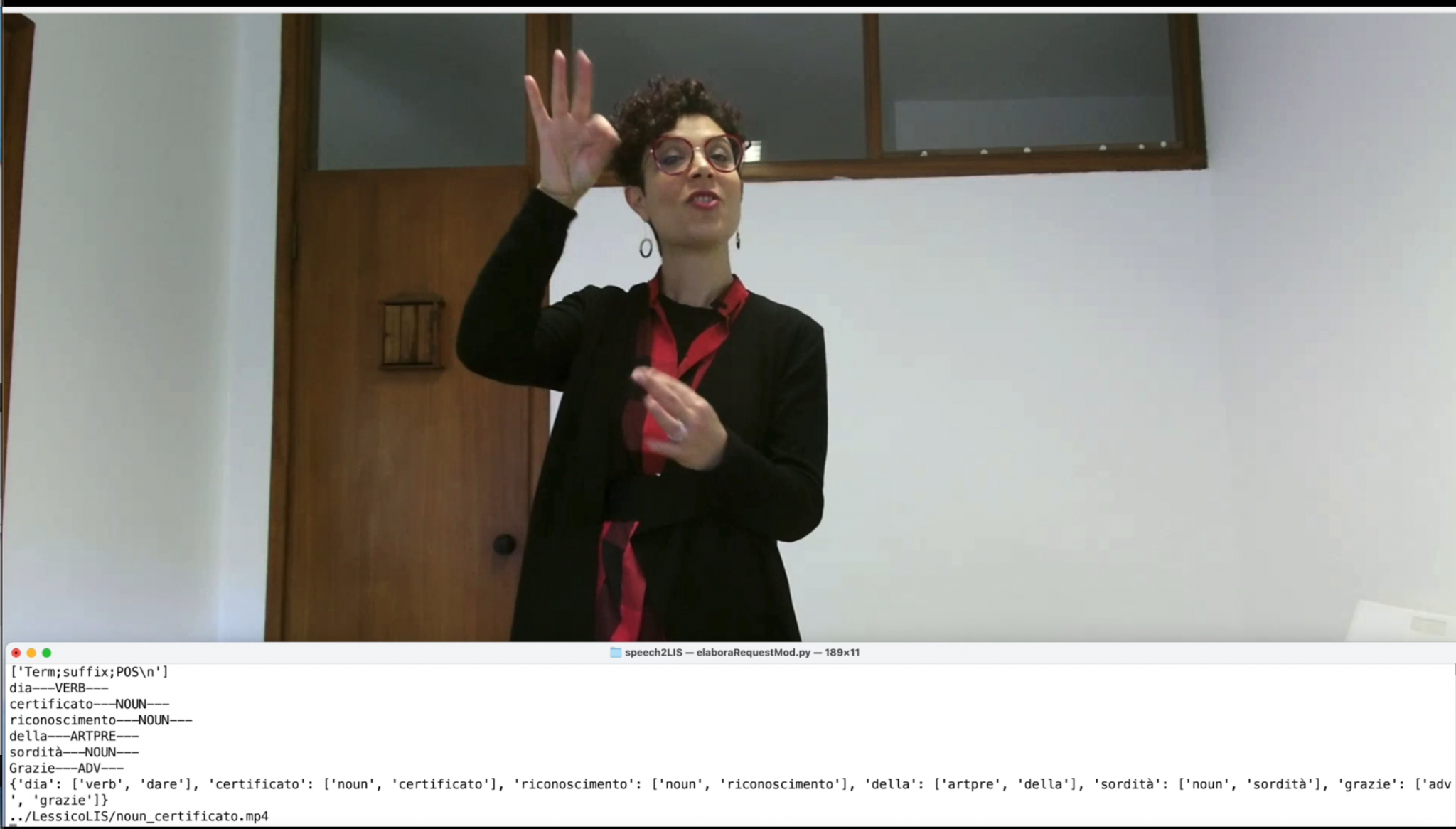

Il nostro approccio per affrontare questa sfida si è basato sull’utilizzo di modelli di deep learning caratterizzati da architetture di reti neurali artificiali complesse. Il primo step è stato la costruzione di un dataset di video, elaborato con il supporto di esperti LIS e di un team rappresentativo della comunità di persone sorde. Questi dati, opportunamente processati, hanno costituito l’input per il secondo step: l’addestramento di una adeguata rete neurale artificiale in grado di riconoscere segni prodotti davanti ad una webcam, traducendoli in forma testuale o vocale, favorendo così l’interlocuzione tra udenti e non udenti.

Il progetto, frutto della collaborazione fra l’Assessorato regionale della Sanità – Direzione generale delle politiche sociali, Sardegna Ricerche e il CRS4, si è classificato al primo posto nella graduatoria nazionale dei progetti regionali di inclusione sociale delle persone con ipoacusia, ed è stato ammesso al finanziamento a valere su Fondi Nazionali della Presidenza del Consiglio dei Ministri, Ufficio delle politiche in favore delle persone con disabilità.

Eventi e Living Lab

17 marzo 2022 - Evento di presentazione del progetto.

Per il CRS4, sono intervenuti all’evento l’Amministratore Unico Giacomo Cao, la ricercatrice Erminia Leonardi e Maria Paola Casula, interprete LIS e consulente del progetto con Alessandra Mura, esperta di lingua e cultura sorda. Durante l’evento è stato mostrato il video di presentazione del progetto, prodotto dal CRS4 e ideato e realizzato da Marco Spanu.

“…tutte le disabilità andrebbero ascoltate per capire i bisogni e garantire una piena accessibilità.” (Alessandra Mura, docente LIS sorda)

13 aprile 2022 - Primo Living Lab

Il primo di una serie di eventi territoriali partecipativi, organizzati per sperimentare e lavorare concretamente sulle tecnologie e le innovazioni proposte dal progetto, con un panel di operatori scelti in collaborazione con la Direzione regionale delle politiche sociali, i comuni di riferimento e gli URP regionali.

L’evento si è aperto con una fase interattiva e di formazione tenuta da Maria Paola Casula (interprete LIS) e da Alessandra Mura (docente Lis sorda). La seconda parte della giornata, curata da Marco Spanu, Alessandra Mura, Davide Porta e Maria Paola Casula, è stata dedicata all’incremento dell’attuale vocabolario previsto dal progetto mediante la registrazione video di vocaboli espressi nella Lingua dei Segni Italiana.

La presentazione di Erminia Leonardi all’evento di presentazione del 17 marzo 2022.

18 maggio 2022 - Secondo Living Lab

Ne corso del secondo Living Lab, è stata illustrata una ulteriore attività di sperimentazione che ha riguardato il processo di traduzione dalla lingua italiana parlata alla Lingua dei Segni Italiana.

I risultati dimostrano che il passaggio dalla lingua parlata alla Lingua dei Segni Italiana è un obiettivo che oggi sembra essere raggiungibile, ma ad alcune determinate condizioni e in ambiti specifici, avendo a disposizione un lessico di segni LIS opportunamente creato.

La presentazione di Franco Tuveri al secondo Living Lab del 18 maggio 2022.

31 maggio 2022 - Terzo Living Lab

Tecnici, esperti del Linguaggio dei segni e persone sorde, si sono confrontati per capire quali siano le problematiche legate all’utilizzo degli algoritmi di Intelligenza artificiale per l’interpretazione del linguaggi dei segni, nel corso del terzo Living Lab che si è tenuto come i precedenti all’Ex Manifattura Tabacchi di Cagliari.

La presentazione di Andrea Manchinu al terzo Living Lab del 31 maggio 2022.

Evento Finale Ipoacusia 1 [21 giugno 2022]

Tecnologie

Realizzazione del dataset CRS4-LIS

Il dataset CRS4-LIS – elaborato con il supporto di esperti LIS e di un team rappresentativo della comunità delle persone sorde – è costituito da 120 vocaboli della lingua italiana, scelti tra quelli più ricorrenti nelle interlocuzioni dei sordi con la Pubblica Amministrazione.

In particolare, per la realizzazione di CRS4-LIS sono state coinvolte 15 persone sorde, di varia età e sesso. Durante l’attività di laboratorio prevista dal progetto sono stati aggiunti altri segnanti, sia udenti che sordi, portando il loro numero complessivo a 27. La maggior parte dei video è stata registrata utilizzando il dispositivo Kinect v2, un prodotto originariamente sviluppato da Microsoft per la console Xbox 360, sensibile al movimento del corpo umano, che permette la registrazione di video in diverse modalità contemporaneamente: video RGB, Depth, estrapolazione scheletro del segnante, infrarossi. Per questo progetto sono stati utilizzati soltanto i video del tipo RGB (per un totale di 3240 campioni), con risoluzione 512×512 e frame rate di 20 f/s.

L'algoritmo di riconoscimento dei segni della LIS

Durante l’attività di progetto sono state analizzate ed utilizzate due differenti architetture di reti neurali artificiali convoluzionarie (CNN), entrambe del tipo “sheleton based”:

- cvpr21chal-slr: Con questa CNN, realizzata dal team di ricerca della Northeastern University di Boston, è stato possibile raggiungere accuratezze di previsione del segno del 95%.

- crs4-ann-lis: Questa CNN, del tipo LSTM, realizzata in-house, richiede circa 120-150 esempi per segno ed è stata testata solo sui segni del dataset della lingua dei segni turca AUTSL , raggiungendo accuratezze di precisione del 92%.

Speech to LIS

Un’altra attività di sperimentazione all’interno del progetto ha riguardato il processo di traduzione dalla lingua italiana parlata alla Lingua dei Segni Italiana. I risultati ottenuti appaiono incoraggianti. Il passaggio dalla lingua parlata alla Lingua dei Segni Italiana è un obiettivo che oggi sembra essere raggiungibile, ma ad alcune determinate condizioni. Alcune prove effettuate dimostrano che il passaggio dall’italiano parlato all’italiano segnato può essere realizzato, per mezzo della Natural Language Processing, avendo a disposizione un lessico di segni LIS opportunamente creato.

Un vero processo di traduzione dall’Italiano parlato alla LIS è qualcosa di decisamente più complesso, che si potrebbe realizzare, nel breve periodo, con raffinamenti progressivi e in un contesto specifico. Tale strumento sarebbe in grado di rappresentare un messaggio in italiano parlato nella Lingua dei Segni Italiana